算力租赁平台如何保证计算能力的稳定供应?核心技术与保障体系解析

发布日期:

2025-06-27 14:32:21

本文链接

https://www.idcsp.com//help/2944.html

本文关键词

在 AI 训练、科学计算、大数据分析等场景中,计算能力的稳定供应直接决定任务成败。但许多用户对算力租赁平台的稳定性存疑:如何避免算力突然中断?高负载时如何保障资源可用?本文将从技术架构、资源调度、容灾机制等维度,拆解算力租赁平台确保稳定供应的核心逻辑,为企业和开发者选择平台提供决策参考。

一、硬件集群的「超规模冗余架构」:从物理层构建稳定性基础

1. 分布式集群的「算力池化」设计

算力租赁平台通常采用大规模分布式集群架构,将数千台服务器(含 GPU/CPU 节点)通过高速网络互联,形成统一的「算力资源池」。这种设计的核心优势在于:

资源弹性调度:单台服务器故障时,任务可自动迁移至其他节点,避免单点失效(类似云计算中的「多副本容错」机制)

异构算力融合:混合部署 NVIDIA A100、H100、AMD MI300 等不同型号 GPU,以及 CPU 算力节点,根据任务类型动态匹配最优资源

2. 硬件冗余的「三重保障」机制

保障维度 | 具体措施 | 效果示例 |

节点级冗余 | 每台服务器配置双电源、双网卡,关键部件(如 GPU)采用热插拔设计 | 某 GPU 核心故障时,系统可在 30 秒内隔离故障部件并维持任务运行 |

集群级冗余 | 按 15%-20% 比例设置「热备用节点」,实时监控并自动填补故障节点算力缺口 | 当 10% 的集群节点因故障离线时,备用节点可在 5 分钟内接管全部任务 |

数据中心级冗余 | 跨地域部署多个数据中心(如华东、华北、华南),通过专线互联形成「算力网格」 | 某数据中心因自然灾害中断时,任务可在 15 分钟内切换至异地集群继续运行 |

二、智能调度系统:让算力资源「按需流动」的核心引擎

1. 任务优先级与资源预留机制

算力租赁平台通过动态资源调度算法(如基于 QoS 的分级调度)实现稳定供应:

· 高优先级任务保障:为 AI 训练等关键任务预留 30% 的集群算力,即使在资源紧张时也能优先分配(类似航空业的「头等舱优先登机」规则)

· 弹性抢占策略:对低优先级任务(如数据预处理),在资源不足时可临时回收算力,但会提前 5 分钟通知并保存任务状态

2. 实时负载均衡的「算力水流模型」

平台采用类似「水循环系统」的调度逻辑:

1. 实时监控:通过 Prometheus 等工具每秒采集各节点的 CPU/GPU 利用率、内存带宽、网络延迟等 200 + 指标

2. 智能分流:当某节点负载超过 80% 时,调度系统自动将新任务路由至负载较低的节点(类似交通系统的「实时路况导航」)

3. 预测性调度:基于历史数据和任务特征,提前 2-4 小时预测算力需求高峰,预分配资源至目标节点

三、网络与存储的「高速通道保障」:消除算力传输瓶颈

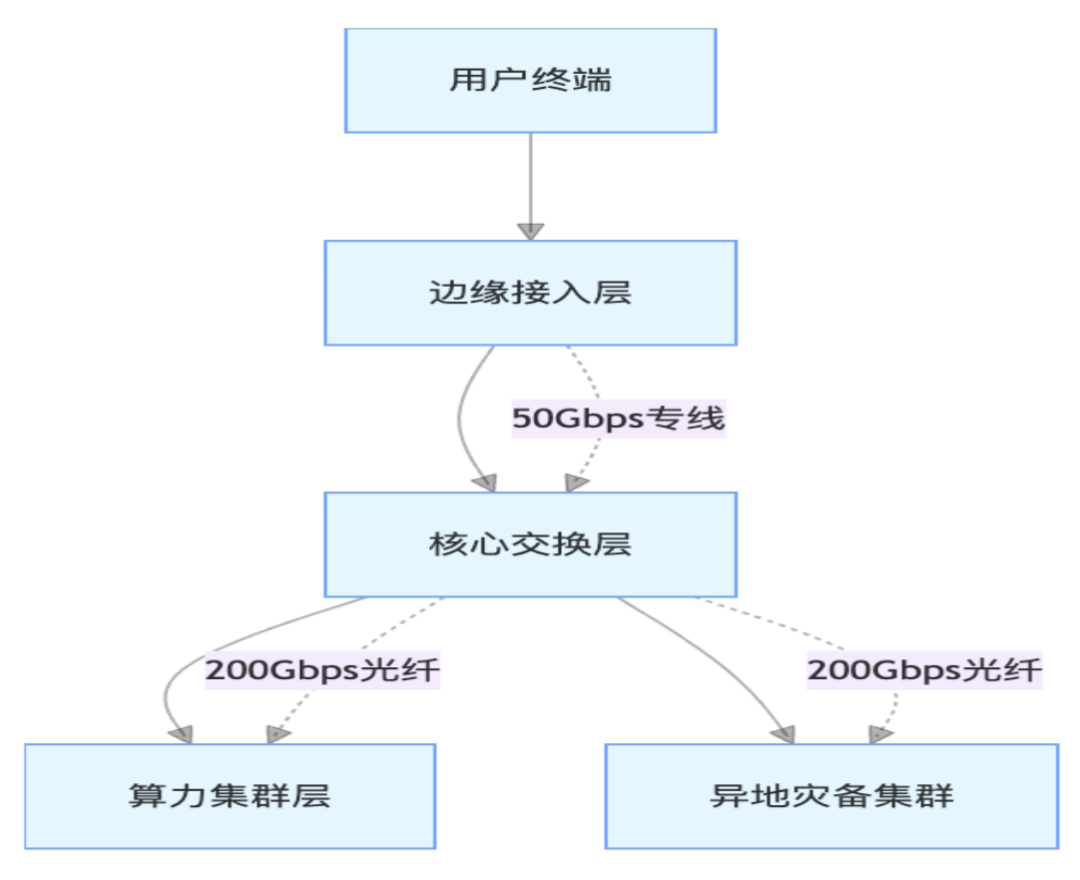

1. 三层网络架构的低延迟设计

· 边缘接入层:在全国主要城市部署接入节点,用户通过就近节点接入,降低初始延迟

· 核心交换层:采用 Spine-Leaf 架构,集群内节点间延迟 < 10 微秒,满足分布式训练的通信需求

· 异地互联:数据中心间通过运营商专线互联,带宽不低于 200Gbps,保障跨地域任务迁移效率

2. 存储与算力的「本地化协同」

为避免数据读取成为瓶颈,平台采用存储 - 算力一体化部署:

· 本地高速存储:每个算力节点配置 NVMe SSD(读写速度 > 7000MB/s),存储任务临时数据

· 分布式文件系统:采用 Ceph 等架构,将热数据缓存至算力集群附近,减少远程读取延迟

· 数据预取机制:根据任务进度,提前将下一阶段所需数据加载至节点本地存储

四、全链路监控与容灾体系:从「被动响应」到「主动预防」

1. 四维监控体系的实时预警

监控维度 | 关键指标 | 预警阈值 | 响应措施 |

硬件健康 | GPU 温度、显存错误率、电源功率 | 温度 > 85℃/ 错误率 > 0.1% | 自动降频或隔离故障设备 |

算力性能 | 浮点运算效率、并行任务数、内存带宽利用率 | 算力利用率 <60% 或> 95% | 调整任务分配或扩容资源 |

网络质量 | 数据包丢失率、往返延迟、带宽利用率 | 丢包率 > 1%/ 延迟 > 50ms | 切换网络链路或重启交换机 |

任务状态 | 任务进度、错误日志、资源占用趋势 | 连续 30 分钟无进度更新 | 自动重启任务或迁移至新节点 |

2. 三级容灾机制的「故障隔离」能力

· 第一级:节点自愈:单个 GPU 或 CPU 核心故障时,系统自动屏蔽故障单元,利用剩余核心维持任务(如 A100 的 60 个 SM 单元中某 2 个故障时,其余 58 个仍可运行)

· 第二级:集群迁移:当整台服务器故障时,任务在 30 秒内迁移至同集群内的备用节点,基于 Checkpoint 机制恢复任务状态

· 第三级:异地灾备:关键任务开启异地双活模式,实时同步数据至异地集群,当本地集群整体故障时,自动切换至异地节点(RTO<15 分钟)

五、资源池动态扩展:应对突发算力需求的「弹性魔法」

1. 「现货 + 预留」的混合资源池模式

算力租赁平台通常维护两类资源池:

· 预留资源池:固定分配给长期客户的专用算力,保障核心任务稳定运行(类似「包年套餐」)

· 现货资源池:动态调度的共享算力,通过实时竞价机制满足短期高并发需求(类似「打车软件的动态加价」)

2. 跨平台算力调度的「生态协同」

头部平台会与多家数据中心、云服务商建立合作,形成「算力联盟」:

· 当自有集群资源不足时,自动向合作方采购算力(如阿里云、AWS 的 GPU 资源)

· 通过统一 API 接口管理跨平台资源,对用户呈现统一的算力池视图,实现「无感扩容」

六、服务保障的「硬约束」:SLA 与运维体系的双重保险

1. 量化的服务级别协议(SLA)

正规算力租赁平台会通过合同约定稳定性指标,例如:

· 算力可用性:不低于 99.9%,若未达标按实际故障时长的 3 倍赔偿算力时长

· 性能达标率:承诺 GPU 算力峰值不低于标称值的 95%,否则退还差价

· 故障响应时间:重大故障(如集群级中断)15 分钟内响应,2 小时内解决

2. 7×24 小时的「全栈运维」体系

· 技术团队配置:每 5000 台服务器配备 1 个运维团队(含硬件工程师、算法工程师、网络工程师)

· 主动巡检机制:每日凌晨对集群进行「健康体检」,提前更换接近寿命周期的硬件(如电源、风扇)

· 用户专属支持:为企业客户提供专属技术经理,定期输出算力使用报告并优化资源配置方案

避坑指南:如何判断算力租赁平台的稳定性?

1. 查看集群规模公开数据:正规平台会公示算力节点数量(如超过 10000 台 GPU 服务器)及数据中心分布

2. 测试「压力场景」响应:可提交小规模高负载任务,观察平台在资源紧张时的调度效率(如任务排队时间、算力分配延迟)

3. 要求提供历史可用性报告:查看平台过去 6 个月的 SLA 达标记录,重点关注重大故障次数(应≤1 次 / 季度)

4. 确认异地灾备能力:询问平台是否具备跨地域算力调度能力,以及故障切换的具体测试案例

总结:稳定供应的本质是「系统化能力」

算力租赁平台的稳定供应并非单一技术的结果,而是硬件冗余、智能调度、网络优化、容灾体系、服务保障等多维度能力的系统化集成。对于用户而言,理解这些底层机制不仅能规避选择风险,更能通过与平台的深度协作(如提前提报算力需求、优化任务架构)进一步提升计算稳定性。在算力成为核心生产力的时代,选择具备「全链路稳定保障」的租赁平台,相当于为业务发展配备了「算力稳压器」。

成都算力租赁入口:https://www.jygpu.com

成都算力租赁官方电话:400-028-0032

优选机房

注册有礼

注册有礼

在线咨询

在线咨询

咨询热线:400-028-0032

咨询热线:400-028-0032